يعتبر عمل تدقيق الحقائق في الإعلام عملاً بسيطاً ومليئاً بالتحديات في نفس الوقت، ويُختصر بالتأكُّد من صحة جميع الادعاءات في المقالة. فمثلاً هل المعلومات البسيطة -مثل المسافة بين مدينتين- دقيقة؟ هل الاقتباسات دقيقة؟ هل الادِّعاءات العامة صحيحة؟ إنها مهمة حساسة، وقد أصبحت أكثر أهمية في حقبة من التزييف الفاقع للأخبار، خصوصاً في ظل انتخابات 2016 الرئاسية في أميركا، والانتخابات النصفية المقبلة.

وللتعامل مع هذه المسألة، قام باحثون من إم آي تي ومعاهد أخرى في قطر وبلغاريا بإجراء أبحاث للتوصل إلى طريقة لاستخدام الذكاء الاصطناعي في مساعدة البشر على التعامل مع المشهد الإعلامي المعقد، وأدركوا أن تطوير ذكاء اصطناعي قادر على تدقيق الحقائق في الادعاءات المنفردة يتطلب أولاً اتخاذ خطوة هامة، وهي تحليل مدى موثوقية المواقع الإلكترونية الإخبارية التي تقوم بالنشر؛ ولهذا قرروا تصميم ذكاء اصطناعي قادر على تقييم مدى التزام المواقع الإخبارية بالحقائق، وتحيزاتها السياسية.

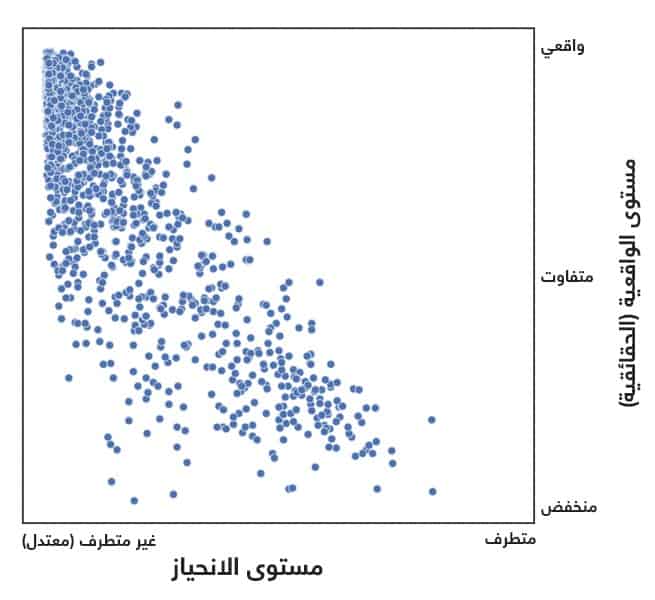

وقد استخدم الباحثون لتدريب نظامهم بيانات من 1,066 موقعاً إلكترونياً مصنفاً في مصدر يسمى التحيز الإعلامي/ تدقيق الحقائق. وبعد ذلك قام الذكاء الاصطناعي بتحليل المعلومات حول المواقع الإخبارية، بما فيها المقالات نفسها، وصفحات ويكيبيديا حول المواقع، وحساباتها على تويتر، وحتى اسم الرابط على الويب. وباستخدام هذه المعلومات، تمكن الذكاء الاصطناعي من تحقيق دقة 65% في توقع مدى التزام الموقع بالحقائق، وحوالي 70% في توقع انحيازه.

ومن أفضل المصادر التي يعتمد عليها الذكاء الاصطناعي مصدر يعتمد عليه البشر أيضاً، حيث يقول ريمي بيلي (باحث في مرحلة ما بعد الدكتوراه في مختبر علوم الحاسوب والذكاء الاصطناعي في إم آي تي، والمؤلف الأول للبحث): “تبين لنا أن ويكيبيديا هام للغاية في هذه المسألة”؛ ويعود هذا إلى أن المعلومات التي قد تحتاج لمعرفتها حول المصدر الإخباري قد تكون موجودة هناك، حيث إن صفحة ويكيبيديا لموقع ذا أونيون -على سبيل المثال- تصنفه على أنه موقع إخباري ساخر بشكل صريح. كما أن صفحة ويكيبيديا لموقع درادج ريبورت تصنفه على أنه محافظ التوجه. ويضيف بيلي أن ويكيبيديا مهم لسبب آخر أيضاً: “إن عدم وجود صفحة ويكيبيديا للموقع يترافق عادة بكونه ضعيف الوثوقية”.

يجب ألا ننسى أن التحقق من الوثوقية الإجمالية للموقع نفسه -وتفقُّد صفحة ويكيبيديا للموقع في حال وجودها- خطوة جيدة للبشر أيضاً، وعلى سبيل المثال فقد أعلنت شركة فيسبوك وشركة مختصة بالأمن السيبراني في أغسطس أنهما اكتشفتا وجود أخبار “غير صحيحة” مصدرها إيران. ومن المواقع التي رُبطت مع إيران موقع ليبرتي فرونت بريس (جبهة الصحافة الحرة)، الذين يصفون أنفسهم بالاستقلالية، ولكن يبدو أنهم في الواقع من المؤيدين لإيران، ومن الجدير بالذكر عدم وجود صفحة ويكيبيديا للموقع (تقدم فيسبوك أيضاً بعض النصائح لنا نحن معشر البشر حتى نتبعها عند البحث عن الأخبار المزيفة).

وبطبيعة الحال ليست مجموعة إم آي تي البحثية هي الوحيدة التي تستخدم الذكاء الاصطناعي لتحليل اللغة هكذا، حيث إن نظام جيغساو الذي طورته جوجل يقوم بقياس مدى الكراهية في تعليقات القراء، كما أن فيسبوك بدأت تلجأ إلى الذكاء الاصطناعي أيضاً لدعم جهودها في الحد من خطاب الكراهية في ميانمار.

وقد اعتمد نظام الذكاء الاصطناعي الذي صمَّمه باحثو إم آي تي على مصدر أكثر أهمية حتى من ويكيبيديا، وهو المقالات على المواقع نفسها، كما تمكن الذكاء الاصطناعي من تحليل ما بين 50 و150 مقالة على كل موقع إخباري لتحليل اللغة المستخدمة فيها. يقول بيلي: “تحاول المواقع شديدة التحيز أن تلعب على عواطف القراء، وهي تستخدم لغة من نوع مختلف”، وذلك بالمقارنة مع المواقع الرئيسية وسطية التوجه.

يقول بيلي إنهم يرغبون في زيادة تعقيد نظامهم، وقد وضعوا هدفاً لهذه المرحلة يقوم على “إطلاق طريقة تفكير جديدة حول التعامل مع هذه المشكلة”.