قد يتم خداع الطرق المصممة لاكتشاف التزييف العميق كما أكد علماء الكمبيوتر للمرة الأولى في مؤتمر «WACV 2021» الذي أُجري على الإنترنت في الفترة من 5 إلى 9 يناير/كانون الثاني عام 2021.

وأكد باحثون من جامعة كاليفورنيا في سان دييغو ذلك في في ورقة بحثية نُشرت أمس الاثنين. إذ أنه يمكن هزيمة أجهزة الكشف عن طريق إدخال المدخلات التي يشار إليها على أنها أمثلة عدائية في جسم كل فيديو. الأمثلة العدائية هي مدخلات يتم التلاعب بها بالكاد، مما يؤدي إلى تحفيز تقنيات ذكاء اصطناعي لارتكاب خطأ بطريقةٍ شبيهة بتقنيات دراسة النماذج الآلية. بالإضافة إلى ذلك، أكد الباحثون أن الاعتداء يعمل بالرغم من ضغط الأفلام.

صرح أحد الباحثين في جامعة كاليفورنيا في سان دييغو: «يكشف بحثنا أن الاعتداءات على أجهزة الكشف عن التزييف العميق قد تكون تهديداً حقيقياً للعالم. الأمر الأكثر إثارة للقلق هو أننا نُظهر أنه من الممكن صنع تزييف عميق قوي للخصم حتى عندما لا يكون الخصم على دراية بالأعمال الداخلية لنموذج دراسة الآلة الذي يستخدمه الكاشف».

آلية كشف التزييف

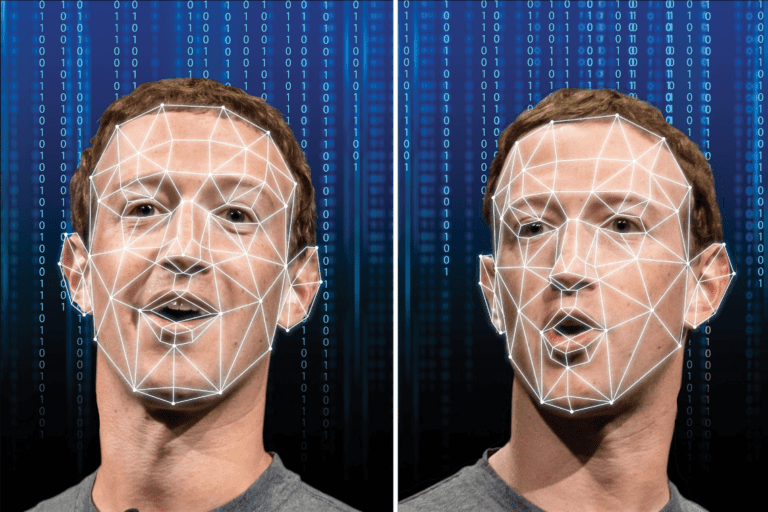

يتم تعديل وجه الموضوع في تقنية التزييف العميق لإنشاء لقطات معقولة بشكل مقنع لمناسبات لم تحدث بالفعل بأي حال من الأحوال. نتيجةً لذلك، تولي أجهزة الكشف عن التزييف العميق اهتماماً للوجه في تلك مقاطع الفيديو؛ أولاً تقوم بمراقبته وبعد ذلك يتم تمرير معلومات الوجه التي تم اقتصاصها إلى عصبونات الآلة التي تحدد ما إذا كان حقيقياً أم تخيلياً. على سبيل المثال، لا يكون بريق العينين واقعياً في عمليات التزييف العميق، لذلك تولي أجهزة الكشف اهتماماً لحركات العين كإستراتيجية واحدة لتحقيق قوة الإرادة هذه. تعتمد أجهزة كشف التزييف العميق المتطورة على أساليب تعلّم الآلة لكشف الأفلام الزائفة.

أثار الكشف المتعمق للأفلام الزائفة عبر منصات التواصل الاجتماعي اعتبارات مهمة في جميع أنحاء العالم، مما أعاق بشكل كبير مصداقية الوسائط الرقمية، حسبما أشار الباحثون. صرح أحد الباحثون القائمون على الدراسة: «إذا كان لدى المهاجمين بعض المعلومات عن نظام الكشف، فسيصممون المدخلات للتركيز على النقاط العمياء للكاشف وتجاوزها».

ابتكر الباحثون حالة عدائية لكل وجه في جسم فيديو. ومع ذلك، في حين أن العمليات المعتادة المشابهة لضغط الفيديو وتغيير حجمه عادةً ما تخفي الأمثلة المعادية من الصورة، إذ يتم إنشاء هذه الأمثلة لمقاومة هذه عمليات الكشف. تقوم خوارزمية الهجوم بذلك عن طريق التقدير عبر مجموعة من تحويلات الإدخال كيف يصنف النموذج الصور على أنها حقيقية أو مزيفة. وبالاستفادة من ذلك، يُستخدم ذلك التقدير لإعادة صياغة الصور بطريقة تجعل الصورة العدائية المزيفة تظل فعالة حتى بعد الضغط وفك الضغط

يتم بعد ذلك إدراج نموذج الوجه المعدل في جميع إطارات الفيديو. ومن ثم تكرار الطريقة لجميع الإطارات داخل الفيديو لإنشاء فيديو زائف عميق كامل. يمكن استخدام الهجوم على أجهزة الكشف التي تعمل على معالجة إجمالي إطارات الفيديو بدلاً من التركيز على الوجه.

نسب نجاح عالية في مراوغة الكاشف

فحص الباحثون اعتداءاتهم على كاشف التزييف في احتمالين؛ أحدهما حيث يكون للمهاجمين دخول كامل إلى نموذج الكاشف، متضمناً تقنية التعرف على الوجه وهيكل نموذج التصنيف ومعاييره. والثاني حيث يمكن للمهاجمين أن يختبروا نموذج التعلم الآلي فقط لتحديد فرص تصنيف الجسم على أنه حقيقي أو زائف. في الحالة الأولى؛ كانت نسبة نجاح الاعتداء أعلى من 99% للأفلام غير المضغوطة، و 84.96% بالنسبة للأفلام المضغوطة. أما في الحالة الثانية، كانت نسبة النجاح 86.43% للأفلام غير المضغوطة و 78.33% للأفلام المضغوطة. وهذا هو العمل الأساسي الذي يوضح الهجمات الناجحة على أجهزة كشف التزييف العميق الحديثة.

كتب الباحثون: «للاستفادة من أجهزة الكشف عن التزييف العميق هذه في المراقبة، فإننا نعتقد أنه من المهم الحكم عليها في مواجهة خصم متكيّف يدرك هذه الدفاعات ويحاول عمداً إفشال هذه الدفاعات. كما أن أحدث الاستراتيجيات الحالية لاكتشاف التزييف العميق يمكن ببساطة تجاوزها إذا كان لدى الخصم معلومات كاملة وحتى جزئية عن الكاشف».

لتعزيز أجهزة الكشف، يدافع الباحثون عن طريقة تتعلق بما يُعرف عموماً بـ«التدريب المنافس»؛ حيث يستمر الخصم التكيّفي في إنتاج فيديوهات مزيفة عميقة جديدة قد لا ترصدها أحدث أجهزة الكشف الحالية طوال فترة التدريب؛ ويستمر الكاشف في التحسين من أدائه لاكتشاف التزييف العميق الجديد.

اقرأ أيضاً: ما هو التزييف العميق؟