يسمح لنا الذكاء الاصطناعي أن نكلّف الآلات بتنفيذ بعض المهمات، وقد بدأت الآلات بوضع الإشارات على صورنا، وقيادة سياراتنا، والتحليق بطائراتنا بدون طيار. تتخذ هذه الأنظمة بعض القرارات الخاطئة بين الحين والآخر أثناء عملها، كما رأينا في حادث سيارة تسلا الذي تسبب به الربان الآلي، أو سماع أمر صوتي بشكل خاطئ، ولكن بحثاً جديداً يقترح أن القراصنة المعلوماتيين ذوي الخبرة في الذكاء الاصطناعي قادرون على إرغام الخوارزميات على اتخاذ قرارات خاطئة، وقد تكون مؤذية.

حقق الباحثون أول خطوة نحو تأكيد وجود هذه الهجمات في العالم الحقيقي عندما أجبروا أحد أنظمة الذكاء الاصطناعي على تحديد الصور بشكل خاطئ، في أكثر من 97% من التجارب، وذلك باستخدام صور ملتقطة بكاميرا هاتف ذكي. قد تكون التغييرات المطبقة على الصور، المطبوعة على الورق والمصورة بكاميرا هاتف ذكي، غير واضحة بالنسبة للعين البشرية، ولكن خارج المخبر قد يعني هذا الفرق ما بين رؤية أو عدم رؤية سيارة ذاتية القيادة لإشارة التوقف.

"يمكنك أن تتخيل الأمر كشخص يوقع شيكاً يبدو وكأنه بقيمة 100 دولار أميركي ويقرأه الصراف الآلي بقيمة 1000 دولار"

يقول إيان جودفيلو، باحث في OpenAI ومؤلف مشارك في البحث: "يمكنك أن تتخيل الأمر كشخص يوقع شيكاً يبدو وكأنه بقيمة 100 دولار ويقرأه الصراف الآلي بقيمة 1000 دولار". كما يقول أن هذه الهجمات قد تستخدم للتلاعب بنتائج محرك البحث، وذلك بخداع خوارزمية تعليم الآلة لتعتقد أن الصورة أفضل، أو من قبل مؤسسة مالية لخداع الذكاء الاصطناعي المخصص للمضاربة بالأسهم لدى شركة منافسة وجعله يتخذ قرارات سيئة.

لم يسمع جودفيلو عن استخدام هذا النوع من الهجمات في العالم الحقيقي من قبل، ولكنه يقول أنه شيء يجب على الباحثين في مجال الذكاء الاصطناعي النظر إليه بجدية.

ليست الأبحاث حول خداع الذكاء الاصطناعي بالأمر الجديد، وقد كانت موجودة منذ سنوات، ولكن لم تتمكن الأبحاث السابقة من إثبات إمكانية حدوث أمر كهذا بصور ملتقطة بكاميرا عادية لأشياء حقيقية. أما البحث، الذي قامت به مؤسستا جوجل وOpenAI التي يدعمها إيلون ماسك، يؤكد أنه يمكن تطبيق هذه الهجمات بنجاح، حتى بوجود تغييرات في الإضاءة، والمنظور، وعدسات الكاميرا، والمعالجة الرقمية.

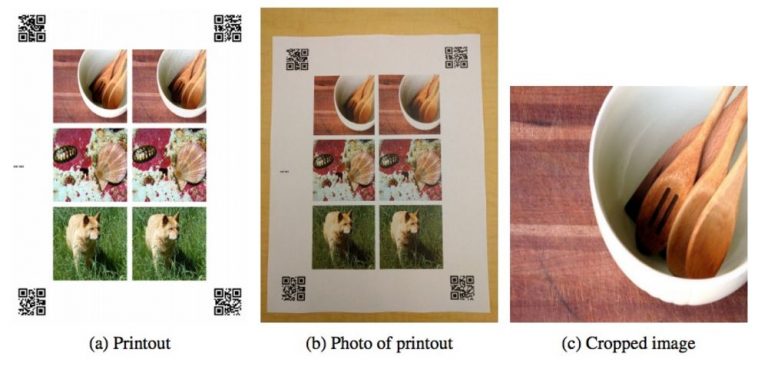

لاختبار قابلية هذه الأنظمة للخداع، قام الفريق بطباعة صور معدلة قليلاً، وتم استخدامها بنجاح للخداع من قبل إذا تم تلقيمها للخوارزمية مطبوعة على الورق جنباً إلى جنب مع صور غير معدلة. ومن قم قاموا بتصوير الورق بكاميرا الهاتف الذكي نيكسوس 5 إكس.

قام الباحثون باقتطاع الصور المطبوعة، ومن ثم طبقوا عليها الخوارزمية المعتادة للتعرف على الصور. ولم تفشل الخوارزمية في تحديد الصور وحسب، بل كانت حتى عاجزة عن إعطاء الجواب الصحيح بين أفضل 5 أجوبة، وذلك في 97% من الحالات. غير أن النتائج انخفضت وفقاً لبعض التغييرات في تعديل الصور، خصوصاً التعديلات الكبيرة والتي يمكن للبشر البارعين تحديدها بنجاح أكبر.

كان الهدف فقط جعل الذكاء الاصطناعي غير قادر على رؤية أشياء يراها عادة في الوضع الطبيعي، على الرغم من أن هذه الصور المعدلة كانت تُرى كأشياء أخرى في الأبحاث السابقة. لم يأخذ الباحثون في الحسبان نوع الكاميرا المستخدمة، ولكنهم يتوقعون أن تعديل العدسات قد يحسن من النتائج.

اعتمدت أبحاث أخرى على نفس الطريقة، ولكن باستخدام الصوت، لخداع هواتف أندرويد وجعلها تزور مواقع إلكترونية وتغير من إعداداتها عبر أوامر صوتية خبيثة. وقد تمكنت هذه المجموعة، المكونة من باحثين من جامعة جورجتاون وجامعة كاليفورنيا في بيركلي، من تعديل الأوامر الصوتية المسجلة، مثل "OK Google"، وتشويهها بحيث تكاد تصبح غير مفهومة للبشر.

كتب باحثو جورجتاون وبيركلي في ورقتهم التي قدمت إلى ندوة يوزنيكس لأمن المعلومات في أغسطس الماضي: "يمكن بث الأوامر الصوتية الخفية أيضاً من مكبر صوت في حدث عام، أو ضمن فيديو واسع الانتشار على يوتيوب، بحيث يزداد مدى وتأثير الهجوم المنفرد".

يمكن لهجوم عام كهذا أن يجعل الهواتف الذكية أو الحواسب (المزودة حديثاً بمساعد شخصي افتراضي) تدخل إلى مواقع ويب خبيثة أو تنشر الموضع الجغرافي لشخص ما على تويتر.

قد تكون هذه الهجمات غير ضارة لبعض مستخدمي الذكاء الاصطناعي، بحيث تكون أسوأ نتائجها صورة خاطئة التصنيف، ولكن بالنسبة للروبوتات، والطيران، والمركبات ذاتية التحكم، وحتى أمن المعلومات، فإن التهديد حقيقي.